AndroidStudio中build.gradle配置信息

1 |

|

buildscript中的声明是gradle脚本自身需要使用的资源。可以声明的资源包括依赖项、第三方插件、maven仓库地址等。而在build.gradle文件中直接声明的依赖项、仓库地址等信息是项目自身需要的资源。

gradle是由groovy语言编写的,支持groovy语法,可以灵活的使用已有的各种ant插件、基于jvm的类库,这也是它比maven、ant等构建脚本强大的原因。虽然gradle支持开箱即用,但是如果你想在脚本中使用一些第三方的插件、类库等,就需要自己手动添加对这些插件、类库的引用。而这些插件、类库又不是直接服务于项目的,而是支持其它build脚本的运行。所以你应当将这部分的引用放置在buildscript代码块中。gradle在执行脚本时,会优先执行buildscript代码块中的内容,然后才会执行剩余的build脚本。

举个例子,假设我们要编写一个task,用于解析csv文件并输出其内容。虽然我们可以使用gradle编写解析csv文件的代码,但其实apache有个库已经实现了一个解析csv文件的库供我们直接使用。我们如果想要使用这个库,需要在gradle.build文件中加入对该库的引用。

1 | buildscript { |

buildscript代码块中的repositories和dependencies的使用方式与直接在build.gradle文件中的使用方式几乎完全一样。唯一不同之处是在buildscript代码块中你可以对dependencies使用classpath声明。该classpath声明说明了在执行其余的build脚本时,class loader可以使用这些你提供的依赖项。这也正是我们使用buildscript代码块的目的。

而如果你的项目中需要使用该类库的话,就需要定义在buildscript代码块之外的dependencies代码块中。所以有可能会看到在build.gradle中出现以下代码:

1 | repositories { |

依赖更新

项目依赖的远程包如果有更新,会有提醒或者自动更新吗? 不会的,需要你手动设置changing标记为true,这样gradle会每24小时检查更新,通过更改resolutionStrategy可以修改检查周期。

1 | configurations.all { |

之前上传aar同一版本到maven仓库,但依赖却没有更新,该怎么办呢?可以直接删除本地缓存,缓存在~/.gradle/caches目录下,删除缓存后,下次运行就会自动重新下载远程依赖了。

取消任务

项目构建过程中那么多任务,有些test相关的任务可能根本不需要,可以直接关掉,在build.gradle中加入如下脚本:

1 | tasks.whenTaskAdded { task -> |

tasks会获取当前project中所有的task,enabled属性控制任务开关,whenTaskAdded后面的闭包会在gradle配置阶段完成。

加入任务

任务可以取消了,但还不尽兴啊,想加入任务怎么搞?前面讲了dependsOn的方法,那就拿过来用啊,但是原有任务的依赖关系你又不是很清楚,甚至任务名称都不知道,怎么搞?

比如我想在执行dex打包之前,加入一个hello任务,可以这么写:

1 | afterEvaluate { |

afterEvaluate是什么鸟?你可以理解为在配置阶段要结束,项目评估完会走到这一步。

variant呢?variant = productFlavors+ buildTypes,所以dex打包的任务可能就是dexCommonDebug。

你怎么知道dex任务的具体名称?Android Studio中的Gradle Console在执行gradle任务的时候会有输出,可以仔细观察一下。

hello任务定义的这么复杂干啥?我直接就叫hello不行吗?不行,each就是遍历variants,如果每个都叫hello,多个variant都一样,岂不是傻傻分不清楚,加上variant的name做后缀,才有任务的区分。

关键来了,dx.taskDependencies.getDependencies(dx)会获取dx任务的所有依赖,让hello任务依赖dx任务的所有依赖,再让dx任务依赖hello任务,这样就可以加入某个任务到构建流程了,是不是感觉非常灵活。

我突然想到,用doFirst的方式加入一个action到dx任务中,应该也可以达到上面效果。

任务监听

你想知道每个执行任务的运行时间吗?你想知道每个执行任务都是干嘛的吗?把下面这段脚本加入build.gradle中即可:

1 | class TimingsListener implements TaskExecutionListener, BuildListener { |

上面是对每个任务计时的一个例子,想要了解每个任务的作用,你可以修改上面的脚本,打印出每个任务的inputs和outputs。比如assembleDebug那么多依赖任务,每个都是干什么的,一会compile,一会generate,有什么区别?看到每个task的输入输出,就可以大体看出它的作用。如果对assemble的每个任务监听,你会发现改一行代码build的时间主要花费在了dex上,buck牛逼的地方就是对这个地方进行了优化,大大减少了增量编译运行的时间。

buildscript方法

Android项目中,根工程默认的build.gradle应该是这样的:

1 | // Top-level build file where you can add configuration options common to all sub-projects/modules. |

一会一个jcenter()这是在干什么?buildscript方法的作用是配置脚本的依赖,而我们平常用的compile是配置project的依赖。repositories的意思就是需要包的时候到哥这里来找,然后你以为com.android.tools.build:gradle:1.2.3会从jcenter那里下载了是吧,图样图森破,不信加入下面这段脚本看看输出:

1 | buildscript { |

结果是这样的:

1 | file:/Applications/Android%20Studio.app/Contents/gradle/m2repository/ https://jcenter.bintray.com/ |

我靠,仓库竟然直接在Android Studio应用内部,所以说你去掉buildscript的jcenter()完全没有关系啊,下面还有更爽的,我们知道有依赖传递,上面classpath 中的gradle依赖gradle-core,gradle-core依赖lint,lint依赖lint-checks,lint-checks最后依赖到了asm,并且这个根目录中的依赖配置会传到所有工程的配置文件,所以如果你要引用asm相关的类,不用设置classpath,直接import就可以了。你怎么知道前面的依赖关系的?看上面m2repository目录中对应的pom文件就可以了。 为什么讲到ASM呢?ASM又是个比较刁的东西,可以直接用来操纵Java字节码,达到动态更改class文件的效果。可以用ASM面向切面编程,达到解耦效果。Android DEX自动拆包及动态加载简介中提到的class依赖分析和R常量替换的脚本都可以用ASM来搞

引入脚本

脚本写多了,都挤在一个build.gradle里也不好,人长大了总要自己出去住,那可以把部分脚本抽出去吗?当然可以,新建一个other.gradle把脚本抽离,然后在build.gradle中添加apply from ‘other.gradle’即可,抽出去以后你会发现本来可以直接import的asm包找不到了,怎么回事?根工程中配置的buildscript会传递到所有工程,但只会传到build.gradle脚本中,其他脚本可不管,所以你要在other.gradle中重新配置buildscript,并且other.gradle中的repositories不再包含m2repository目录,自己配置jcenter()又会导致依赖重新下载到~/.gradle/caches目录。如果不想额外下载,也可以在other.gradle中这么搞:

1 | buildscript { |

获取AndroidManifest文件

ApplicationId versus PackageName提到,gradle中的applicationid用来区分应用,manifest中packageName用来指定R文件包名,并且各个productFlavor 的manifest中的packageName应该一致。applicationid只是gradle脚本中的定义,其实最后生成的apk中的manifest文件的packageName还是会被applicationid替换掉。

那获取R文件的包名怎么搞?要获取AndroidManifest中package属性,并且这个manifest要是起始的文件,因为最终文件中的package属性会被applicationid冲掉,由于各个manifest中的package属性一样,并且非主manifest可以没有package属性,所以只有获取主manifest的package属性才是最准确的。

def manifestFile = android.sourceSets.main.manifest.srcFile def packageName = new XmlParser().parse(manifestFile).attribute(‘package’)

无用资源

transitive = true

transitive dependencies 被称为依赖的依赖,称为“间接依赖”比较合适。

1 | compile('com.meituan.android.terminus:library:6.6.1.16@aar'){ |

在后面加上@aar,意指你只是下载该aar包,而并不下载该aar包所依赖的其他库,那如果想在使用@aar的前提下还能下载其依赖库,则需要添加transitive=true的条件。 排除 transitive dependencies 通过configuration或者dependency可以除去 transitive dependencies:

build.gradle

1 | configurations { |

如果在configuration中定义一个exclude,那么所有依赖的transitive dependency (指定的)都会被去除。 定义exclude时候,或只指定group, 或只指定module名字,或二者都指定。

不是所有的transitive dependency 都可以被去除的,如runtime时候使用到的。一般来说,runtime时候用不到的,或者目标环境及平台已经包含该依赖的可以执行exclude去除。

那exclude选per-dependency还是per-configuration?,大多数情况我们都选用per-configuration,下面是一些使用exclude的典型场合:

- 有licensing问题

- 从远程仓库上无法获取到依赖

- runtime时候用不到

- 有版本冲突

可以给dependencies统一指定transitive为false,再次执行dependencies可以看到如下结果。

1 | configurations.all { |

exclude的疑问

1 | exclude module: 'base_model' |

和

1 | exclude group:'com.name.group' module:'base_model' |

的区别是? 经过测试,二者的作用是完全一样的。

force=true

1 | compile('com.squareup.okhttp:okhttp-mt:2.5.0') { |

如上,我们在依赖okhttp的时候很可能发生冲突,就比如依赖的依赖中也包含了okhttp,这种场合下,就会产生版本冲突的问题,加上force = true表明的意思就是即使在有依赖库版本冲突的情况下坚持使用被标注的这个依赖库版本。

gradle命令

- gradlew projects:查看所有项目

- gradlew tasks:查看任务信息

- -b参数指定其他的构建文件

- -p:参数指定要使用的构建文件的文件夹,例如我们将subdir中的构建文件重命名为build.gradle,然后运行gradle -q -p subdir hello

- gradle -q projects 列出所有项目的信息(-q静默参数,功能是只显示任务输出,不显示其他构建过程的输出)

- gradle -q tasks 列出所有任务

- gradle help –task someTask:显示任务帮助

- 使用-m参数可以以Dry Run的方式运行Gradle,在这种方式下不会执行任何任务,只会列出这些任务的执行顺序

在运行Gradle的时候我们不用完整输入任务名称,如果任务的前几个字母就可以区分任务,我们就可以只输入这几个字母。比如gradle d相当于gradle dist。另外Gradle还支持驼峰命名法的缩写。比如说我们可以运行gradle cT,相当于gradle compileTest。

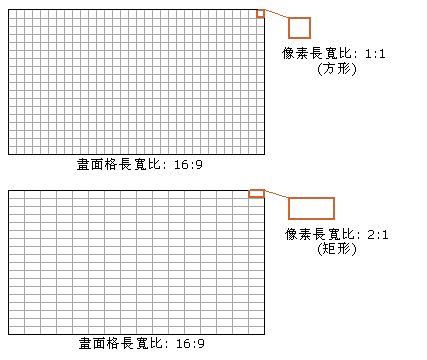

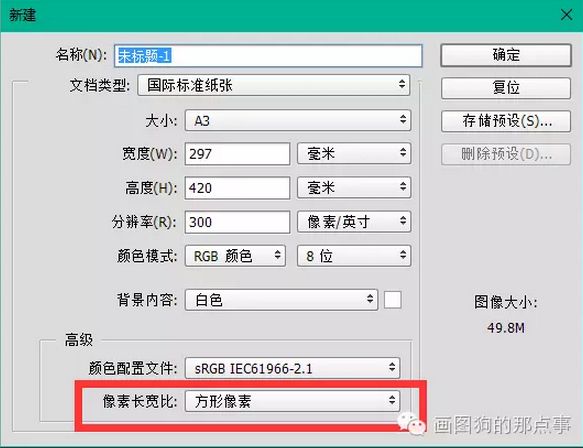

组成这张图的单位是一个格子一个格子的颜色小方块组成的,这种小方块就叫做像素。像素就是图像显示的基本元素。

组成这张图的单位是一个格子一个格子的颜色小方块组成的,这种小方块就叫做像素。像素就是图像显示的基本元素。